Aggregierte Suche: Eine neue Generation der Sicherheitsprüfung und Datenleck-Rückverfolgbarkeit – inhaltszentriert (Ping32)

11 min

11 min Mit der fortschreitenden digitalen Transformation sind Daten zum zentralen Vermögenswert geworden, der Wachstum und Innovation antreibt. Gleichzeitig werden Risiken von Datenabflüssen zunehmend komplexer und schwerer zu erkennen. Klassische Schutzmechanismen wie DLP (Data Loss Prevention) fokussieren vor allem auf Prävention vor dem Vorfall sowie Kontrolle und Blockierung währenddessen. In einer Welt, in der „Zero Trust“ zum Standard wird und die Angriffsfläche stetig wächst, lassen sich Leckagevorfälle jedoch kaum zu 100 % vermeiden. Damit rückt eine andere Frage in den Mittelpunkt: Wie gelingt nach einem Vorfall eine schnelle, präzise und vollständige Aufklärung inklusive belastbarer Beweissicherung? Genau das ist heute eine Kernanforderung für Security Operations und Compliance-Audits.

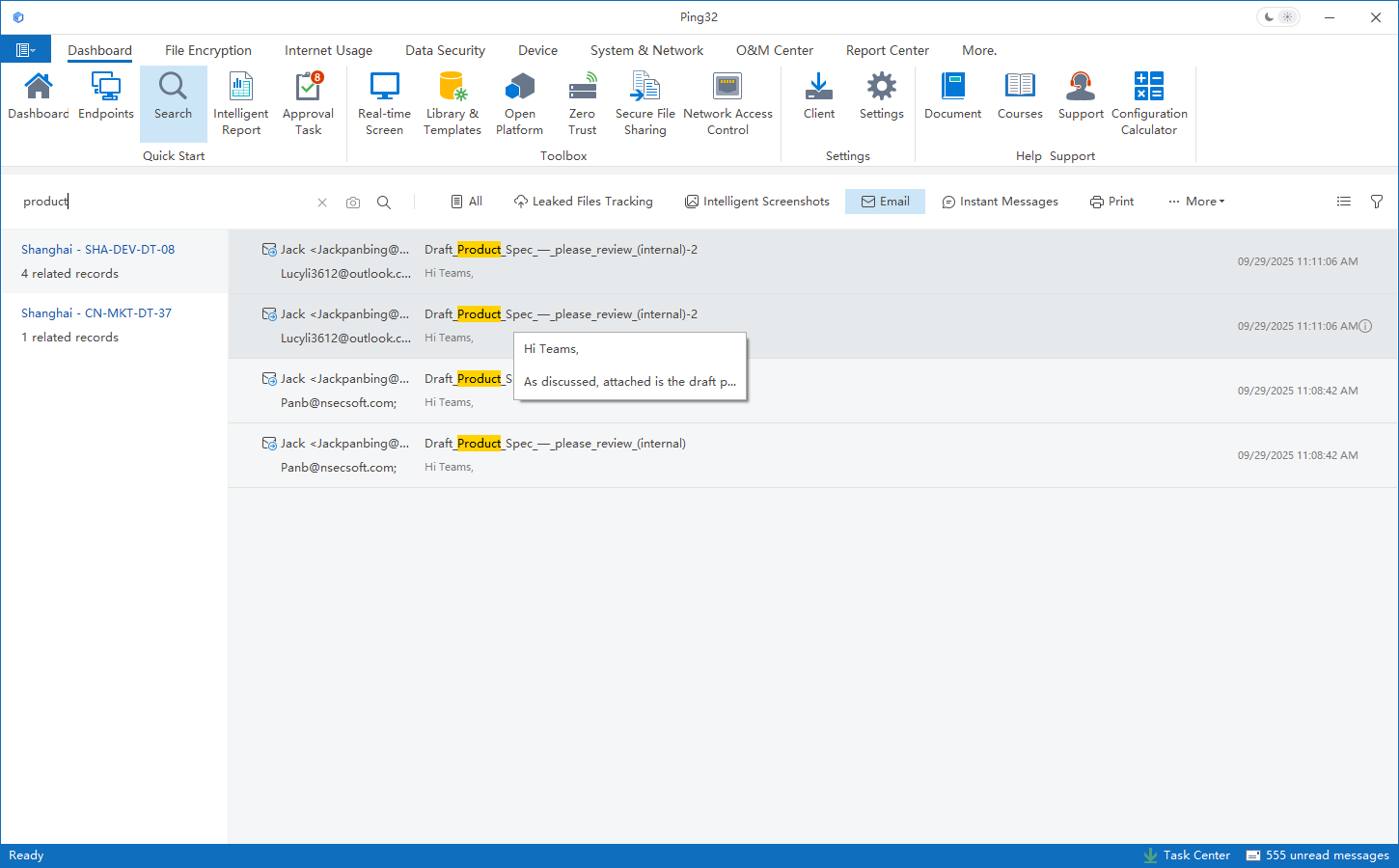

Die von Ping32 vorgeschlagene aggregierte Suche (Aggregated Search) ist ein innovatives Fähigkeitenset für die Incident-Response-Phase. Es geht nicht nur um „schnelleres Log-Suchen“, sondern um eine Neuordnung der Audit-Logik: Aus verstreuten, heterogenen Audit-Daten entsteht eine prüfbare, reproduzierbare Ereigniserzählung. So können Unternehmen selbst aus fragmentierten Hinweisen schnell das Gesamtbild eines Datenlecks rekonstruieren und eine vollständige Beweiskette aufbauen.

1) Ausgangspunkt Incident Response: Das „Signal-Rausch-Verhältnis“ in riesigen Log-Mengen

In Enterprise-Endpunkt-Audit-Umgebungen kann ein einzelnes Gerät pro Tag Hunderte von Ereignissen erzeugen. Unternehmensweit summiert sich das schnell auf zig Millionen bis hin zu hunderten Millionen Datensätze täglich. Wenn ein Sicherheitsvorfall eintritt, ist die zentrale Herausforderung selten „Gibt es Logs?“, sondern das klassische Signal-Rausch-Problem: Wie lassen sich innerhalb einer sehr kurzen MTTR aus massiven, heterogenen Datenmengen die wenigen relevanten „Signale“ extrahieren, die tatsächlich mit dem Datenabfluss zusammenhängen?

In traditionellen Audit- und Trace-Prozessen müssen Administratoren oft in kürzester Zeit mehrere Aufgaben parallel erledigen – jede davon kann zum Engpass werden: zeitliche Eingrenzung über Timestamps und manuelles Abgleichen über mehrere Systeme hinweg; Informationsidentifikation anhand von Metadaten wie Dateiname oder E-Mail-Betreff, die häufig nur unscharfe Treffer ermöglichen; Pfadrekonstruktion durch manuelles Verknüpfen verteilter Log-Einträge mangels automatischer Korrelation; und schließlich eine Beweiskette, die leicht reißt und Audit- oder Rechtsanforderungen nur schwer standhält. Je größer die Datenmengen, desto stärker sinken Effizienz und Genauigkeit klassischer Suchen (RDBMS oder flache Log-Dateien) – und damit die Fähigkeit, moderne Incident Response „schnell, korrekt, vollständig“ umzusetzen.

2) Grundlegende Schwächen traditioneller Audits: Metadatenabhängigkeit und Performance-Limits

Die Grenzen klassischer Audit-Ansätze lassen sich auf zwei Kernprobleme zurückführen: Performance-Engpässe und unzureichende forensische Zuverlässigkeit.

2.1 Performance-Engpässe: Generationsunterschied zwischen relationalen Abfragen und Volltextindex

Viele traditionelle Audit-Tools „suchen“ im Kern, indem sie Metadatenfelder in der zugrunde liegenden Datenbank abfragen – etwa Dateiname, Pfad, Empfänger, Betreff usw. Bei kleinen Datenmengen ist das akzeptabel. Bei zig Millionen oder hunderten Millionen Datensätzen steigen Abfragekosten jedoch stark an, und Antwortzeiten lassen sich kaum noch zuverlässig garantieren.

Ping32 setzt bei der aggregierten Suche auf eine verteilte Volltext-Index-Architektur (z. B. nach dem Prinzip eines inversen Index wie bei Elasticsearch). Durch Vorab-Indexierung des gesamten Audit-Datenbestands wird die Suche von „Scannen“ auf „Index-Treffer“ umgestellt. Das ermöglicht stabile Reaktionszeiten selbst bei großen Datenvolumina und hoher Parallelität – eine Grundvoraussetzung für wirksame Incident Response.

2.2 Forensische Zuverlässigkeit: Dateinamen sind keine belastbare Grundlage für Rückverfolgung

Noch grundlegender ist die Frage der Beweisqualität. Traditionelle Verfahren stützen sich stark auf Metadaten wie Dateiname, Titel oder Pfad – doch in realen Leak-Szenarien sind Metadaten leicht veränderbar und leicht zu umgehen: Dateien können beliebig umbenannt werden; Angreifer können durch Verschlüsselung, Komprimierung oder Extension-Änderung Metadaten-basierte Kontrollen aushebeln; derselbe sensible Inhalt kann in mehreren Versionen unter unterschiedlichen Namen verteilt auftreten.

Damit sind metadatenbasierte Audits oft eher „wahrscheinlichkeitsbasiert“ als „verlässlich rückverfolgbar“. Sobald Metadaten zerstört oder gefälscht werden, kann die Audit-Kette vollständig reißen. Ping32 betrachtet Metadaten-Suche daher als Triage- und Erstdiagnosefähigkeit, nicht als Endpunkt der Aufklärung.

3) Der Kernnutzen der aggregierten Suche: Von Metadaten zu inhaltsbasierter Tiefenübereinstimmung

Der entscheidende Durchbruch liegt in Content Awareness: Der Fokus verschiebt sich von „Wie heißt die Datei?“ zu „Was ist der Inhalt?“.

3.1 Fragmentierte Hinweise: Suchen nach „Inhaltsstücken“ statt nach Dateien

In der Praxis liegt bei Datenabflüssen oft nicht die vollständige Originaldatei vor, sondern nur Fragmente: ein Abschnitt sensibler Geschäftsdaten, eine Telefonnummer, eine Ausweisnummer, eine Kundennummer, ein interner Projektcode oder ein Satz aus einem Screenshot bzw. einem PDF-Auszug. Solche Hinweise lassen sich nicht sauber auf Log-Felder abbilden und treffen über Dateinamen/Betreff häufig nicht zuverlässig.

3.2 Wie inhaltsbasierte aggregierte Suche umgesetzt wird

Ping32 realisiert die inhaltsbasierte Tiefenübereinstimmung über drei Mechanismen:

-

Vollständige Inhaltsindexierung: Bereits bei der Datenerfassung extrahiert das System Text aus Dateiinhalten, E-Mail-Texten, IM/Chat-Nachrichten usw. und erstellt einen Volltextindex.

-

On-Demand-Suche nach dem Vorfall: Keine aufwendigen Vorab-Regeln oder komplexe Regex-Konfiguration notwendig; nach dem Vorfall kann der Administrator beliebige fragmentierte Hinweise (Text, Nummern, Keywords) direkt eingeben.

-

Schnelles Matching und automatische Aggregation: Das System matcht im globalen Index in hoher Geschwindigkeit und aggregiert automatisch alle relevanten, typübergreifenden Aktivitäten, die denselben Inhalt enthalten.

So bleibt der Inhalt auch dann auffindbar, wenn er umbenannt, aufgeteilt oder vielfach kopiert wurde – solange er erfasst und indexiert wurde.

4) Erweiterte Fähigkeiten: Visuelle Intelligenz und Korrelationsanalyse zur Beseitigung von Audit-Blindspots

Für eine wirklich „lückenlose“ Prüfung reicht Textindexierung allein nicht aus. Aggregierte Suche kombiniert deshalb visuelle Intelligenz und Korrelationsanalyse, um auch Umgehungsszenarien abzudecken.

4.1 Visuelle Intelligenz: Tiefe Integration von OCR und Bild-zu-Bild-Suche

In Unternehmen liegt viel sensible Information in unstrukturierten Formaten vor: Scans, Bilder, PDFs, Screenshots. Für klassische Audits sind diese Dateien häufig „Black Boxes“.

Ping32 integriert visuelle Verfahren in Erfassung und Indexierung:

-

OCR (Optical Character Recognition): Extraktion von Text aus Bildern/Scans, anschließende Aufnahme in denselben Volltextindex – dadurch werden Bilder „über ihren Inhalt“ durchsuchbar.

-

Bild-zu-Bild-Suche (Image-to-Image Search): Extraktion visueller Merkmale und Ähnlichkeitsabgleich. Administratoren können ein verdächtiges Bild als Hinweis hochladen; das System findet visuell sehr ähnliche Bilder im gesamten Audit-Datenbestand. Das hilft besonders bei Zuschnitt, Unschärfe oder Re-Encodierung, wenn OCR an Grenzen stößt.

Damit lassen sich auch „Screenshot-Exfiltration“ oder „Drucken–Scannen“-Umgehungen über Text im Bild oder über visuelle Signaturen zurückverfolgen.

4.2 Ereignisaggregation: Korrelation über einen Datenherkunfts-Graphen

Der entscheidende Unterschied zur klassischen „Punkt-Suche“: Statt isolierter Log-Einträge liefert die aggregierte Suche eine vollständige Ereigniskette.

Das System modelliert jede Aktion (Erstellen, Kopieren, Komprimieren, Senden, Hochladen usw.) als Knoten und Datenflüsse als Kanten. Nach der inhaltsbasierten Identifikation eines Startknotens kann das System entlang vordefinierter Korrelationsmodelle automatisch erweitern und heterogene Aktionen verbinden – kanalübergreifend (Dateien, E-Mail, IM/Chat, Cloud-Sync, USB), zeitübergreifend (vom Entstehen bis zur Exfiltration) sowie objektübergreifend (User, Endpunkt, Inhalt, Empfänger/Ziel). Das Ergebnis ist eine „Datenfluss-Karte“, die den gesamten Leak-Verlauf visuell und nachvollziehbar rekonstruiert – mit deutlich höherer Effizienz und Beweisqualität.

5) Fazit: Aggregierte Suche definiert das neue Paradigma der Sicherheitsprüfung

Aggregierte Suche ist nicht einfach „ein schnelleres Suchfeld“. Sie steht für einen Paradigmenwechsel: von passiver, logzentrierter Recherche hin zu aktiver, inhaltszentrierter Ereignisrekonstruktion.

Sie adressiert drei zentrale Pain Points moderner Security Operations:

-

Effizienz: Durch Volltextindexierung bleiben Antwortzeiten im Millisekunden- bis Sekundenbereich auch bei großen Datenmengen erhalten – entscheidend für Incident Response.

-

Genauigkeit: Inhaltsbasierte Tiefenübereinstimmung reduziert die Abhängigkeit von leicht veränderbaren Metadaten; selbst fragmentierte Hinweise führen zu präziser Lokalisierung.

-

Vollständigkeit: Visuelle Verfahren und Graph-Korrelation schließen Blindspots unstrukturierter Daten und aggregieren verteilte Aktionen zu einer vollständigen Ereigniskette – Grundlage für lückenlose Rückverfolgung und belastbare Beweise.

Wenn Audits nicht mehr auf „Zufallstreffer“ angewiesen sind und Suchergebnisse direkt zur Wahrheit eines Vorfalls führen, erreicht der Datenschutz- und DLP-Ansatz einer Organisation erst das Niveau kontrollierbar, vertrauenswürdig und rückverfolgbar.

FAQ – Aggregierte Suche & Leak-Rückverfolgung

1) Was ist der größte Unterschied zur klassischen Log-Suche?

Klassische Suche ist stark feld-/metadatenbasiert und liefert oft fragmentierte Ergebnisse. Aggregierte Suche ist inhaltszentriert, korreliert verteilte Daten automatisch und präsentiert eine Ereigniskette – ideal für Incident Response und Beweissicherung.

2) Ist aggregierte Suche dasselbe wie Elasticsearch?

Nein. Volltextindexierung ist eine wichtige technische Basis, aber aggregierte Suche umfasst zusätzlich Inhalts-Extraktion, Multi-Source-Indexierung, automatische Aggregation/Korrelation und Ereignisrekonstruktion als Graph.

3) Kann ich nur mit einem Textfragment oder einer Telefonnummer suchen?

Ja. Wenn das Element in erfassten und indexierten Dateiinhalten, E-Mails oder IM/Chat-Nachrichten vorkommt, kann es gefunden und mit zugehörigen Aktionen aggregiert werden, um den Datenfluss zu rekonstruieren.

4) Funktioniert das nach Umbenennen, Komprimieren, Verschlüsseln oder Extension-Wechsel?

Umbenennen und Extension-Wechsel beeinflussen inhaltsbasierte Suche meist nicht. Komprimierte Dateien sind indexierbar, soweit Inhalte extrahierbar sind. Bei nicht entschlüsselbaren Dateien erfolgt die Rekonstruktion über Exfiltrationshandlungen, Dateimerkmale und Vor-/Nach-Korrelationen (abhängig vom Erfassungs- und Analyseumfang).

5) Kann ich sensible Inhalte in Bildern/Scans/PDFs/Screenshots finden?

Ja. OCR macht Text aus Bildern indexierbar, und Bild-zu-Bild-Suche findet ähnliche Bilder auch bei Zuschnitt/Unschärfe/Re-Encodierung.

6) Welche Exfiltrationskanäle lassen sich korrelieren?

Typischerweise Dateioperationen, E-Mail, IM/Chat, Cloud-Drive-Synchronisation und externe Geräte (USB). Zusätzlich werden Zeit- und Objektbezüge (User/Endpunkt/Empfänger) korreliert, um eine Datenfluss-Karte zu erstellen.

7) Für welche Teams/Szenarien ist das geeignet?

Für SOC/Security Operations, Internal Audit & Compliance sowie Data-Security/DLP-Teams – besonders für Leak-Ermittlungen, Audit-Nachweise, Post-Mortems großer Vorfälle und kanalübergreifende Rückverfolgung.

Kontakt

Kontakt