Vor dem Hintergrund einer tiefgreifenden Verzahnung von digitaler Transformation und hybriden Arbeitsmodellen wird der Lebenszyklus von Unternehmensdaten strukturell neu geformt. Das traditionelle, am Rechenzentrum ausgerichtete, zentralisierte Speichermodell entwickelt sich zunehmend zu einem verteilten Nutzungsmodell, bei dem die Endgeräte der Mitarbeitenden (Endpoints) den zentralen Berührungspunkt darstellen: Geschäftsdaten „liegen“ nicht mehr ausschließlich in kontrollierten Fachanwendungen oder auf File-Servern, sondern verteilen sich in großem Umfang auf Endgeräte und werden in der täglichen Zusammenarbeit häufig bearbeitet, weitergegeben und nach außen übertragen.

Diese „Dezentralisierung“ steigert die Produktivität, verlängert jedoch gleichzeitig die Risikofront für Datenabflüsse erheblich. Sobald sensible Daten die klassischen physischen und logischen Grenzen verlassen, sind externe Weitergaben häufig in regelkonforme Geschäftsprozesse eingebettet und weisen dadurch eine hohe Unauffälligkeit und Zufälligkeit auf: Eine kurzfristige Abstimmung, eine eilige Lieferung oder eine abteilungsübergreifende Zusammenarbeit kann bereits zum Ausgangspunkt eines Kontrollverlusts werden.

Zahlreiche Branchen- und Security-Reports kommen übereinstimmend zu dem Schluss, dass sich das Risiko des Abflusses von Datenwerten zunehmend von externen Infiltrationsangriffen hin zu unkontrollierten Handlungen interner Personen verlagert. Ob informeller Transfer über Instant-Messaging-Tools (IM), unautorisierte Uploads auf Web-Plattformen, physische Kopien über Wechseldatenträger (USB) oder auch Druck, Screenshots und andere physische/analoge Ausgaben – ohne wirksame Auditierung und Kontrolle können solche Vorgänge schnell zu tatsächlichen Datenleck-Vorfällen eskalieren.

Für ressourcenbegrenzte KMU ist der Aufbau eines Full-Stack-Sicherheitsökosystems kostenintensiv. Allein auf „präventive“ Regelwerke oder „nachgelagerte“ Log-Analysen zu setzen, reicht für die dynamischen Endpoint-Leakage-Szenarien nicht mehr aus. Unternehmen benötigen eine Fähigkeit zur „In-Process“-Kontrolle (Kontrolle im Moment des Geschehens): Echtzeit-Intervention, präzise Erkennung und dynamische Gegenmaßnahmen – also eine automatisierte, richtlinienbasierte Abwehr im „Millisekunden“-Zeitfenster, in dem eine Datei tatsächlich nach außen geht. Ziel ist: kontrollierbar, auditierbar und mit sofortiger Schadensbegrenzung.

Der „erste Tatort“ des Datenabflussrisikos

In der Praxis ist „nach außen senden“ nicht automatisch „Verstoß“. Im Gegenteil: Externe Weitergaben sind oft ein normaler Bestandteil der Wertschöpfung – Dokumentenabgleich, Lieferantenabstimmung, Kundenauslieferung, Remote-Reviews, eilige Report-Abgaben. Genau diese Abläufe machen Endpoints zum ersten Ausgangspunkt für Datenabfluss – und zugleich zum am schwierigsten zu steuernden und am häufigsten übersehenen Risikofeld.

Endpoint-basierte Exfiltrationsrisiken zeigen typischerweise drei Merkmale:

-

Viele Wege, viele Einstiegspunkte – schwer vollständig abzudecken

Datenabfluss findet nicht nur per E-Mail statt. IM, Browser-Uploads, Cloud-/Drive-Synchronisation, USB-Kopien, Druckausgaben, Screenshot-&-Paste, Datei-Mapping via Remote Desktop – all das kann denselben sensiblen Inhalt nach außen tragen. Punktuelle Kontrollen lassen zwangsläufig blinde Flecken.

-

Stark geschäftsgetrieben – leicht „unter dem Deckmantel legitimer Prozesse“

Viele Vorfälle sind keine bösartigen Angriffe, sondern entstehen in scheinbar plausiblen Workflows: Mitarbeitende schicken Unterlagen privat, um Deadlines zu halten, laden Dateien zur Zusammenarbeit in private Clouds, ersetzen Freigaben durch Screenshots. Je enger der Zeitplan und je intensiver die Kollaboration, desto häufiger werden Regeln „im Namen der Effizienz“ umgangen.

-

Einmal passiert, schwer zu stoppen – hohe Kosten für Nachverfolgung

Endpoint-Exfiltration ist hochgradig unmittelbar: In dem Moment, in dem die Datei versendet wird, verliert das Unternehmen die Kontrolle über Kopien, Weiterleitungen und sekundäre Verbreitung. Selbst wenn die verantwortliche Person nachträglich identifiziert wird, lässt sich die Verbreitungskette oft nicht mehr unterbrechen – übrig bleiben Compliance-Risiken und Behandlungskosten.

Der Kern der Endpoint-Weitergabegovernance ist daher nicht „Verbieten“, sondern: Echtzeit-Erkennung, szenariobasierte Einstufung und abgestufte Maßnahmen, lückenlose Nachvollziehbarkeit/Auditierbarkeit – und bei Bedarf Millisekunden-Sofortstop zur Schadensbegrenzung.

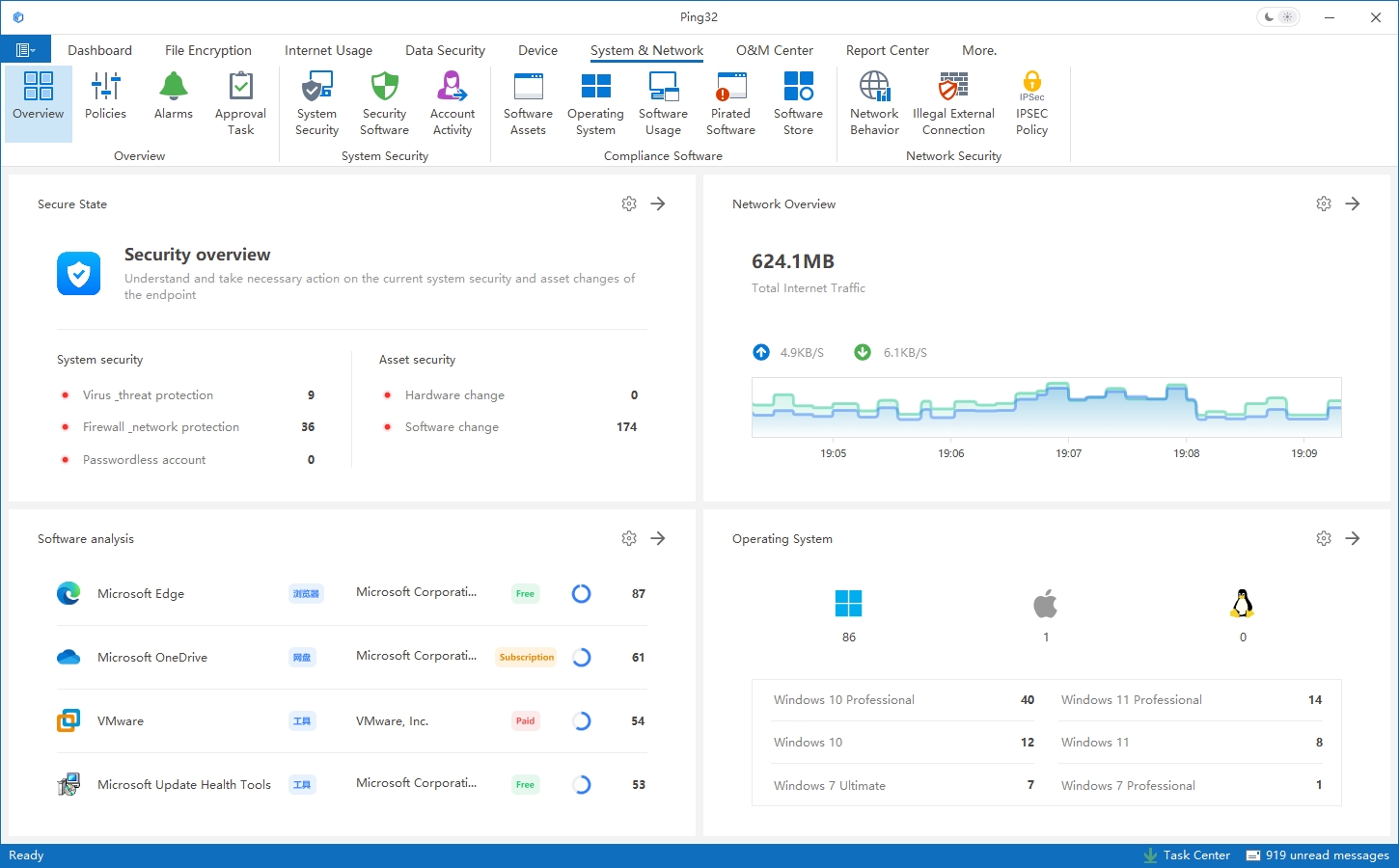

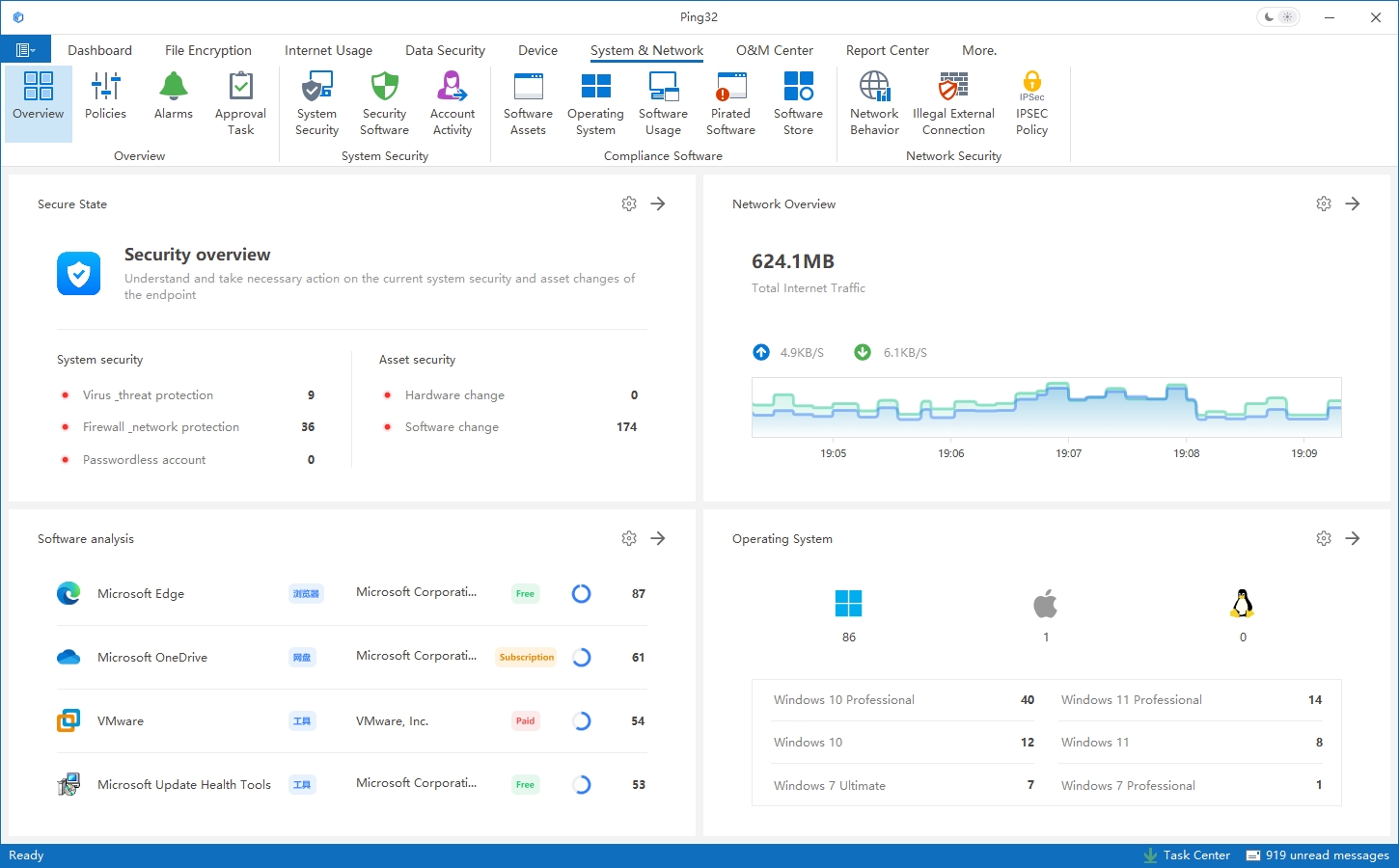

Ping32 Data-Leakage-Protection-Ansatz

Die Endpoint-Sicherheitsmanagement-Plattform von Ping32 integriert eine In-Process-Control-Engine tiefgehend und verlagert die Kontrolllogik in die Ausführungsphase der Dateiweitergabe. Der Kern: ohne die Arbeitsgewohnheiten der Nutzer zu verändern, werden „Weitergabeaktionen“ in Echtzeit analysiert, bewertet und per Richtlinie durchgesetzt. So greift Sicherheit in dem Moment, in dem das Geschäft passiert – statt erst im Nachhinein zu rekonstruieren, „was passiert ist“.

End-to-End-Abdeckung: ein blinder-Flecken-freies Endpoint-Sensing-Netz

Für wirksame Endpoint-Weitergabekontrolle ist der erste Schritt nicht „sofort blocken“, sondern „sehen, unterscheiden, steuern“. Ping32 startet am Endpoint, zerlegt Weitergabe-Ketten entlang realer Geschäftswege und führt sie in einer einheitlichen Governance-Sicht zusammen. Typische Hochrisiko-Szenarien (u. a.):

- Web-Upload-Exfiltration: Analyse und Steuerung von Browser-Uploads zu Drittseiten, Online-Formularen, Kollaborationsplattformen, Ticket-/Work-Order-Systemen, Cloud-Drives/Cloud-Speichern.

- E-Mail-Exfiltration: Anhänge, Empfänger-Domain-Policies, Freigabe-/Block-Trigger bei Erkennung sensibler Inhalte.

- Wechseldatenträger: USB-Kopien, Exporte, Massenkopien, Datentransfer zwischen getrennten Netzen (Air-Gap) – typische Hochrisiko-„physische“ Abflüsse.

- Druck & Screenshot als „analoge Ausgabe“: Audit von Druckjobs, Inhaltszuordnung, Screenshot-Verhalten und Verbreitungsketten inkl. Policy-Intervention.

- App-übergreifende Transfers: Copy/Paste, Drag&Drop, Speichern unter, Komprimieren/Packaging, Formatkonvertierung – „Umgehungs“-Aktionen mit Bedarf an korrelierter Kontrolle.

- Offline-/Schwachnetz-Szenarien: Richtlinien bleiben auch ohne Verbindung aktiv; Logs werden nach Reconnect automatisch synchronisiert – für kontinuierliche Governance.

Mit der End-to-End-Abdeckung können Unternehmen in einer Plattform erreichen: Visualisierung der Weitergaben, Risiko-Einstufung, Policy-Orchestrierung sowie Audit und Nachverfolgung – und damit von „punktueller Kontrolle“ zu „Ketten-/Pfad-Governance“ aufsteigen.

Intelligente Inhaltswahrnehmung (DCI)

Nur Aktionen zu sehen reicht nicht. Effektive Governance muss beantworten: Wie sensibel ist die Datei, die gerade nach außen geht? Lohnt sich ein Block? Wie minimiert man Business-Impact?

Dafür führt Ping32 eine Engine zur Identifikation sensibler Inhalte (Data Content Identification, DCI) ein und gibt der In-Process-Control die Fähigkeit, Daten „zu verstehen“. Über vordefinierte Keyword-Listen, Regex, File-Fingerprints, Metadatenattribute und strukturelle Merkmale kann das System die Sensitivität bewerten und klassifizieren.

Basierend auf dem DCI-Ergebnis kann Ping32 differenzierte Reaktionen auslösen – „wertbasiert“ und „szenariobasiert“:

- Silent Audit (Audit): Niedrigrisiko-Aktionen unauffällig protokollieren, Business-Kontinuität sichern.

- Realtime Alert (Alert): Verdächtige Aktionen sofort an Admins melden, Risiken frühzeitig sichtbar machen.

- Enforced Block (Block): Regelwidrige Exfiltration kritischer Assets in Millisekunden blockieren, damit Daten den Schutzbereich nicht verlassen.

- Flexible Approval (Approval): Sicherheitsentscheidung ans Business zurückgeben und per Online-Freigabeworkflow Sicherheit und Effizienz ausbalancieren.

Damit sind Policies nicht mehr ein grobes „durchlassen/stoppen“, sondern können – abhängig von Sensitivität und Kontext – den passenden Behandlungspfad definieren: derselbe Kanal, aber unterschiedliche Maßnahmen je nach Datenwert.

Schrittweise Governance: DLP nachhaltig betreiben

Eine „One-Size-Fits-All“-Vorgabe führt häufig zu Widerstand und Umgehungen. Ping32 setzt daher auf eine nachhaltige, schrittweise Einführung – Sichtbarkeit → Kontrolle → Optimierung –, um eine stabil laufende DLP-Organisation (Data Loss Prevention) aufzubauen.

Phase 1: Erst sichtbar machen, dann standardisieren

Audit als Startpunkt: reale Weitergabepfade, Teamunterschiede und Hochrisikogruppen identifizieren, Baselines erstellen – als Grundlage für spätere Policies.

Phase 2: Stufen- und szenariobasiert steuern, False Positives reduzieren

DCI-Klassifizierung und Kontext-Policies einführen und die Entscheidung von „Kanal“ auf „Inhalt + Aktion + Szenario“ heben – mit geringerer Störung des Betriebs.

Phase 3: Von Block zu Zusammenarbeit – Closed Loop

Durch Alert-Orchestrierung, Freigabeprozesse, Ausnahme-Management und Beweis-/Forensik-Mechanismen wird aus „Einmal-Block“ eine kontinuierliche Governance-Schleife; Sicherheit wird Teil des Workflows statt Zusatzlast.

Phase 4: Kontinuierlicher Betrieb und Policy-Iteration

Aus Audit-Daten und Incident-Learnings Regeln und Sensitivitätsmodelle fortlaufend verbessern – weg von „Erfahrungsgetrieben“ hin zu „Datengetriebener Governance“.

Sicherheit als „Gewissheit“ im Geschäftsfluss

In komplexen, schnelllebigen und stark verteilten Endpoint-Umgebungen ist In-Process-Control der praxisnächste und wirkungsvollste Baustein moderner Data-Leakage-Prevention. Durch kontinuierliches End-to-End-Sensing der Weitergabepfade, kombiniert mit intelligenter Content-Erkennung und dynamischer Reaktion, ermöglicht Ping32 die Echtzeit-Risikoerkennung, Sensitivitätsdifferenzierung und policybasierte Maßnahmen – sodass Sicherheitsanforderungen natürlich in jede Dateiweitergabe eingebettet werden.

Das ist nicht nur ein Funktions-Upgrade, sondern eine systemische Weiterentwicklung der Datengovernance: Unternehmen verlassen sich nicht länger primär auf nachträgliche Aufklärung oder manuelle Regeln, sondern etablieren im laufenden Betrieb ein ausführbares, verifizierbares und nachhaltiges Managementsystem. Bei gleichbleibender Datennutzungseffizienz entsteht so eine stabile Basis für Compliance-Audits, Risikokontrolle und langfristige digitale Betriebsfähigkeit – Sicherheit wird zur inneren Fähigkeit statt zur Zusatzbelastung.

FAQ (Häufige Fragen)

Q1: Worin unterscheidet sich Ping32 In-Process-Control von einer klassischen Firewall?

A: Firewalls filtern vor allem Traffic am Netzwerkperimeter. Ping32 wirkt am Endpoint, erkennt Weitergabeaktionen und Dateiinhalte und trifft feingranulare Entscheidungen auf Basis von Nutzer, Anwendung und Kontext – für praxisnähere Kontrolle und schnellere Schadensbegrenzung.

Q2: Können HTTPS-verschlüsselte Web-Uploads erkannt werden?

A: Ja. Ping32 kann über Browser-seitige Fähigkeiten oder Protokollanalyse gängige Web-Upload-Aktionen analysieren und auditieren und gemäß Richtlinie warnen, freigeben oder blockieren.

Q3: Greifen Policies auch im Offline-Betrieb?

A: Ja. Der Ping32 Agent verfügt über eine lokale Policy-Engine, die auch offline blocken und auditieren kann. Nach Wiederverbindung werden Logs automatisch synchronisiert, wodurch die Kontinuität gewährleistet ist.

Q4: Verbraucht DCI (Inhaltsidentifikation) viel Endpoint-Ressourcen?

A: Nein. Ping32 nutzt optimierte Trigger-Scans und inkrementelle Identifikation; in der Regel wird nur beim tatsächlichen Weitergabevorgang kurz bewertet. Der Performance-Einfluss bleibt kontrollierbar.

Q5: Wie verhindert man Umgehungen durch Ändern der Dateiendung?

A: Ping32 unterstützt eine dateisignatur-/merkmalbasierte Erkennung (File Signature/Fingerprint), die Endungs-Tarnung durchdringt und den echten Dateityp bestimmt. In Kombination mit DCI und Policy-Orchestrierung reduziert das Umgehungsrisiken wirksam.

Kontakt

Kontakt

11 min

11 min